Ollama Installation für Einsteiger

Im Podcast „Künstlich Klug” den wir zusammen mit afritz Consulting produzieren erklären wir Euch, wie man selber LLMs betreiben kann und damit ein Maximum an Datenschutz und Unabhängigkeit erreichen kann. Das Tool der Wahl ist hier Ollama. Wem unser Einstieg in Ollama für Entwickler zu sperrig ist, für den haben wir hier eine einsteigerfreundliche Installationsanleitung zusammengetragen.

Was kann Ollama?

Ollama ist ein Programm um LLMs/Chatbots auf eigener Hardware zu betreiben. Neben den „großen“ Modellen von Google, OpenAI, Anthropic und co. gibt es zahlreiche sogenannte „Open Weights“ Modelle, die klein genug sind, um sogar auf dem heimischen PC/Laptop genutzt zu werden. Diese sind zwar nicht ganz so mächtig wie die Flagschiffe der großen Anbieter, aber hier greift das Pareto Prinzip: mit 20% (oder sogar 2%) der Rechenleistung und Modellgröße kann man 80-95% der Leistung (je nach Aufgabe und Modell) der großen Modelle erreichen. Generell gilt: je größer und neuer das Open Weights Modell, desto besser, man sollte sich also von kleinen Modellen nach oben durchtesten, um rauszufinden, welches das größte Modell ist, das auf dem eigenen Computer noch in akzeptabler Geschwindigkeit läuft.

Das praktische an Ollama: die gängigen Open Weights Modelle werden auf Wunsch automatisch heruntergeladen, es gibt eine praktische Übersichtsseite mit Detailinformationen. Unter Windows und Mac gibt es eine grafische Benutzeroberfläche, mit der man gleich loschatten kann. Unter Linux muss man mit der Konsole vorliebt nehmen oder eine alternative Chatoberfläche wie [Librechat nutzen] (https://www.librechat.ai/).

Installation unter Windows

Zunächst muss man sich die Ollama Installationsdatei unter [https://ollama.com/download/windows] herunterladen:

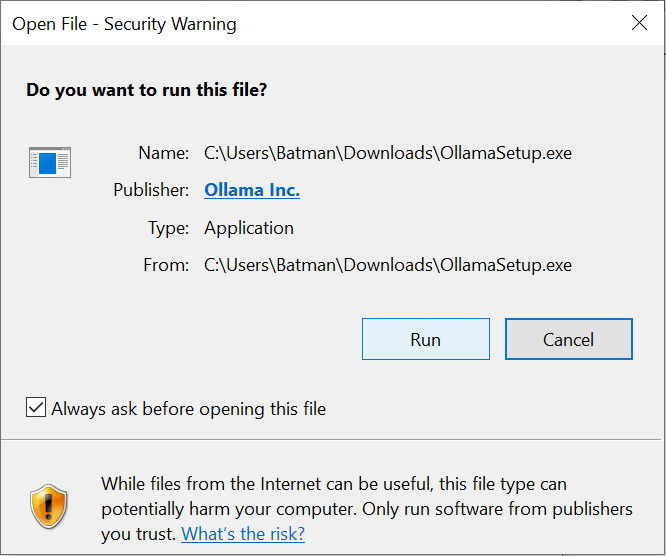

Dann muss man den Installer ausführen. Dafür muss man bestätigen, das man das Programm OllamaSetup.exe ausführen möchte:

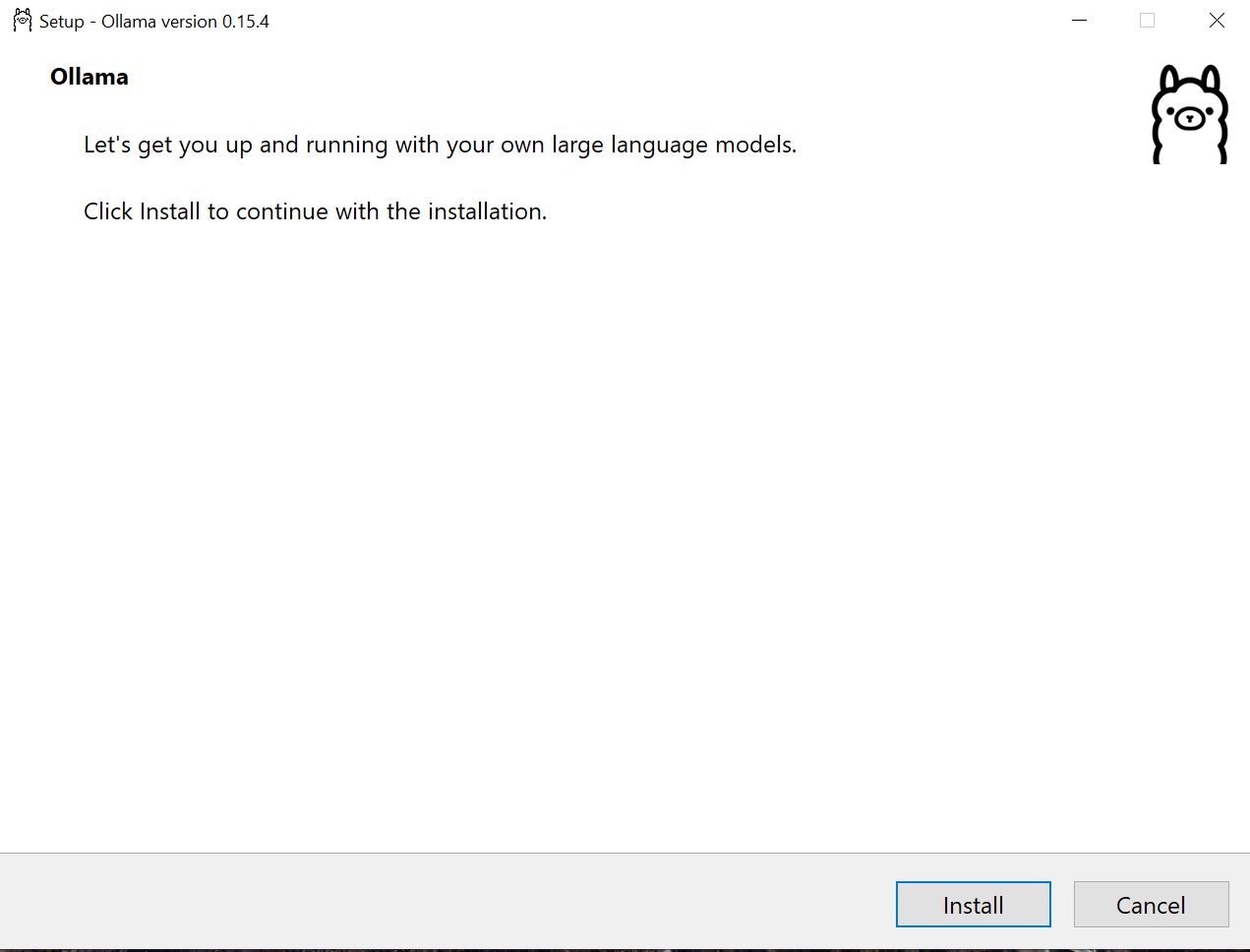

Dann muss man durch einen Klick auf „Install“ die eigentliche Installation starten:

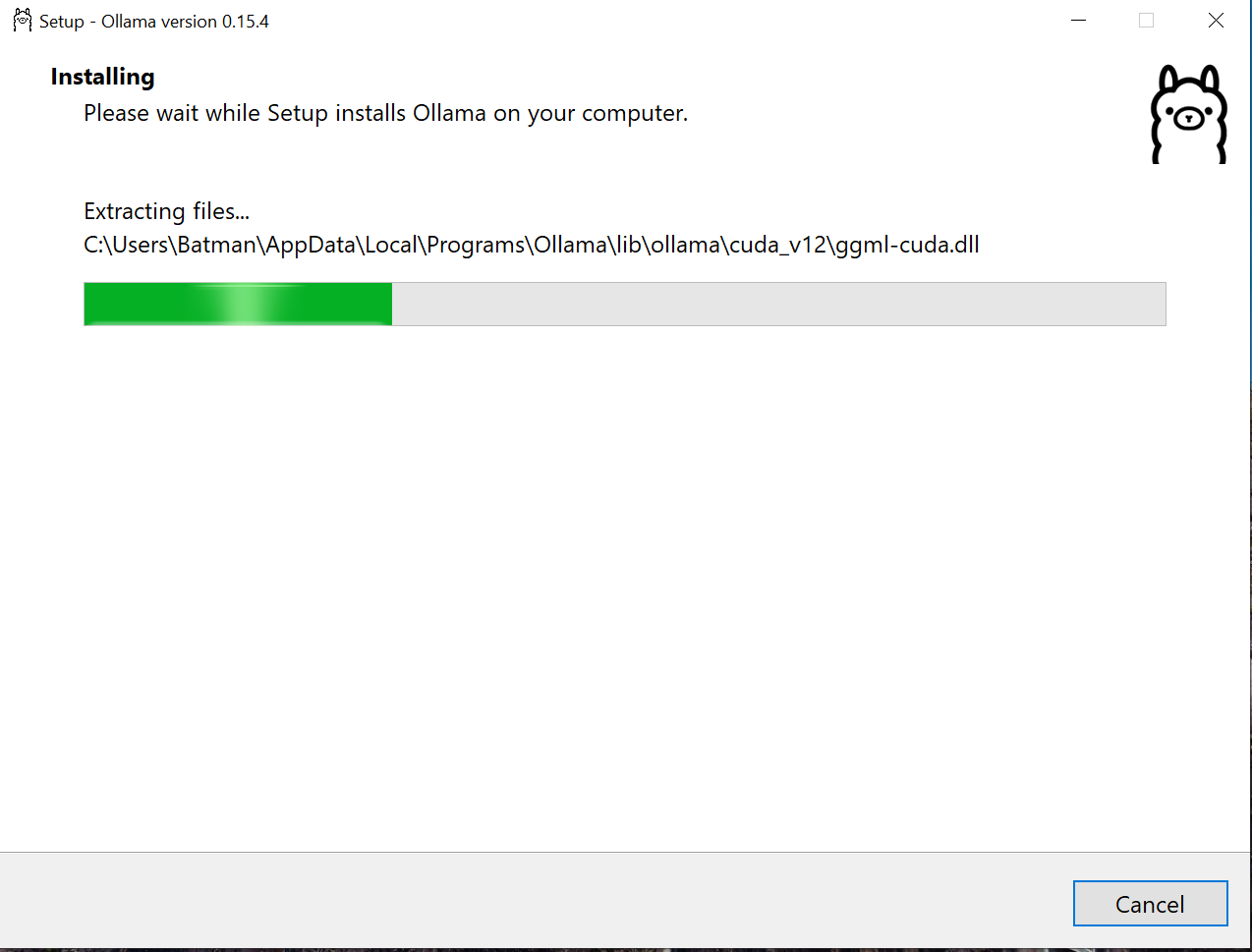

Nun installiert der Installer alle notwendigen Dateien - das kann eine Weile dauern (LLMs werden hier noch nicht installiert):

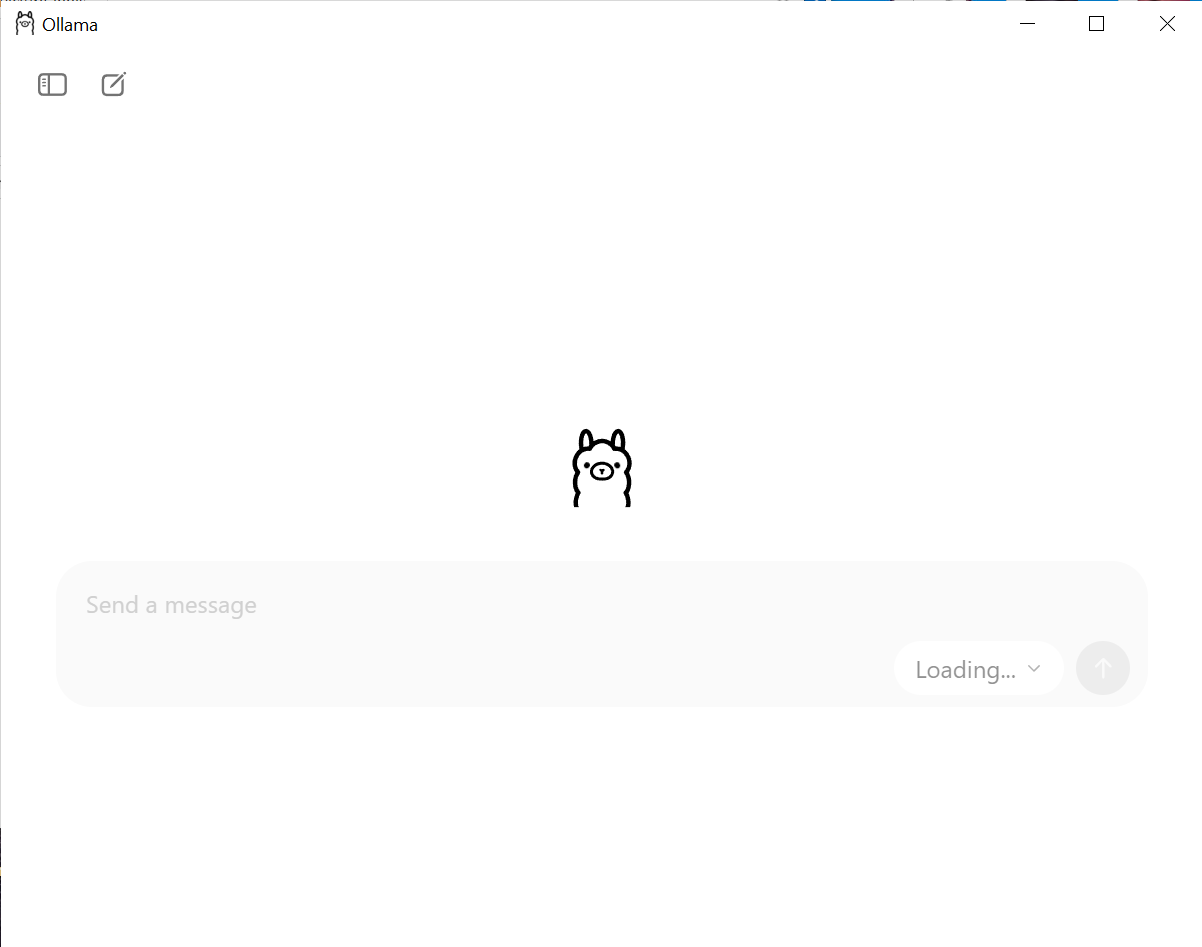

Nun ist die Installation abgeschlossen und man wird mit einem Chat Fenster begrüßt. Man muss allerdings noch einen Moment geduld haben, denn Ollama lädt nun die aktuelle Lister der zum Download verfügbaren LLMs (zu erkennen am ausgegrauten Dropdown Menü unten rechts mit der Beschriftung „Loading…“):

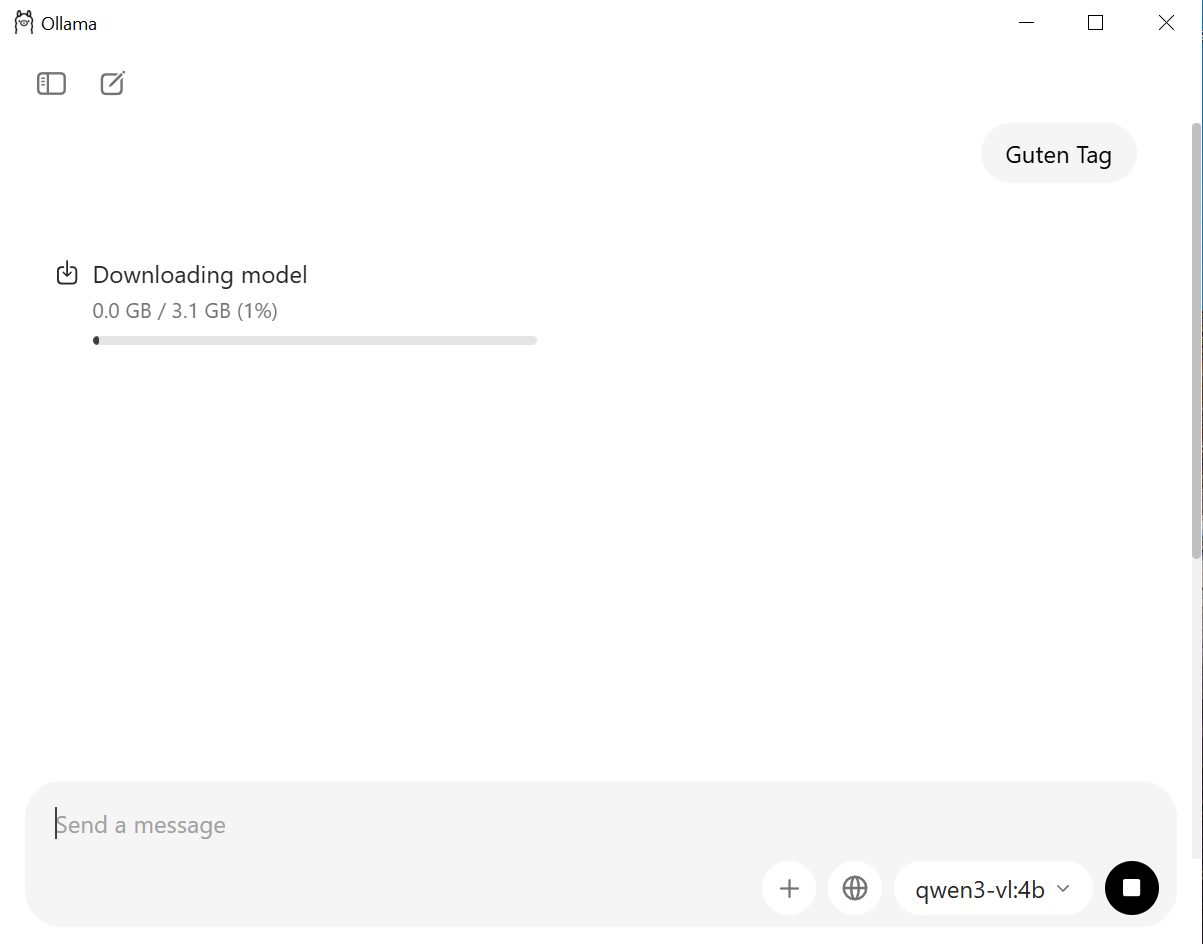

Ist diese Liste aktualisiert, kann man über das Drowpdown Menü das gewünschte Modell zum chatten auswählen. Ist es noch nicht installiert wird es automatisch heruntergeladen, das kann eine Weile dauern. Gute erste Kandidaten sind die qwen3 und gemma Modelle. Die Zahl nach dem Dopplpunkt ist die Anzahl an Parametern in Milliarden (das b kommt vom Englischen „billion“ für Milliarde). Hier sollte man klein anfangen und sich hocharbeiten um zu sehen, was auf dem eigenen Computer gut zu nutzen ist. Modelle ab 2 Milliarden Parameterns sollten (zumindest auf Englisch) mit chatGPT 3.5 mithalten können, ab 8 Milliarden Parametern hat man fast die Leistung von chatGPT 4, bei noch größeren Modellen kommt man immer näher an die großen kommerziellen Modelle heran.

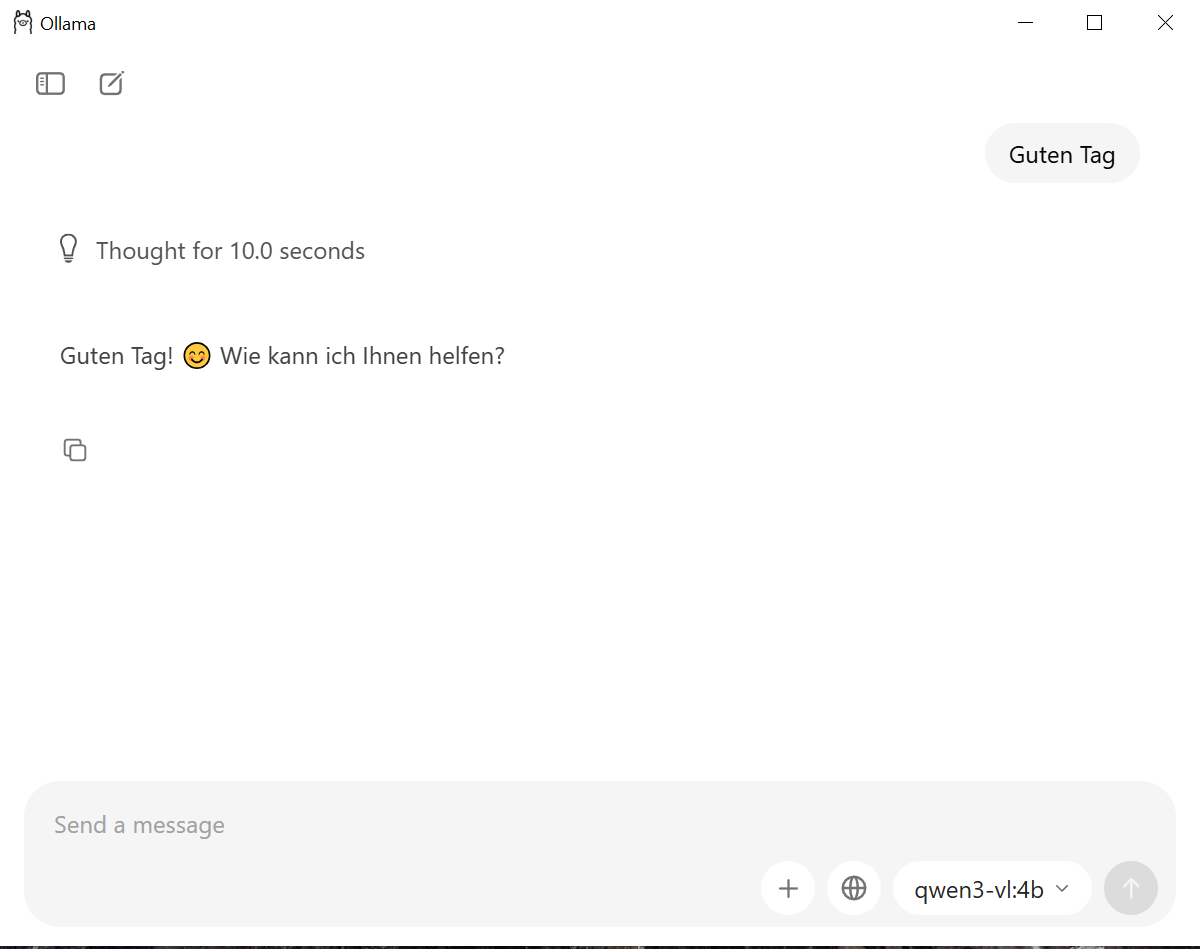

Ist der Download abgeschlossen kann man einfach loschatten - aber vorsicht, „thinking“ / „reasoning“ Modelle denken recht viel nach, da kann die Antwort eine Weile auf sich warten lassen.

Mehr Infos zur Benutzeroberfläche von Ollama findet sich hier: [https://ollama.com/blog/new-app]

Wer möchte, kann mit Ollama auch lokale LLMs in eigene Software integrieren, die Dokumentation findet man hier: [https://docs.ollama.com/]

Installation unter Mac

Gehe auf [https://ollama.com] und klicke auf den Download-Button. Die Installationsdatei landet in deinem Download-Ordner.

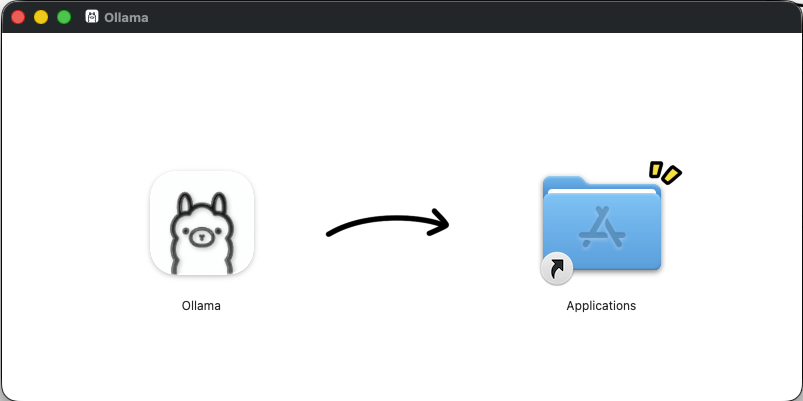

Öffne die heruntergeladene Ollama.dmg-Datei und ziehe das Ollama-Symbol in den Programme-Ordner.

Dann Öffne Ollama aus dem Programme-Ordner - ein kleines Lama-Symbol erscheint in deiner Menüleiste, die App startet! Ab hier geht es genauso weiter wie unter windows im vorigen Abschnitt, da die Benutzeroberfläche unter beiden Betriebssystemen gleich ist.

Installation unter Linux

Unter Linux kann ollama mittels eines installer scripts nach /usr/local installiert werden:

curl -fsSL https://ollama.com/install.sh | sh

Alternativ kann man ollama auch manuell an einen beliebigen Ort installieren, die Anleitung dafür ist hier zu finden: https://docs.ollama.com/linux

Hat man ollama installiert so kann man es mit ollama run <modellname> starten. Die möglichen Modellnamen und die Beschreibung der Modelle findet man hier: https://ollama.com/library Googles “gemma 3” Modell wird zum Beispiel wie folgt gestartet: ollama run gemma3.

Manche Modelle gibt es in mehreren Größen, hier kann man dann die Größe manuell durch einen Doppelpunkt getrennt angeben, z.B.: ollama run gemma3:1b. Gibt mein keine Größe an, so wird die neueste Version des Modells genutzt, auf der Webseite unter der Detailbeschreibung des Modells mit “latest” gekennzeichnet, z.B.: https://ollama.com/library/gemma3 Falls das Modell noch nicht lokal vorhanden ist, so wird es automatisch heruntergeladen, da die Modelle oft größer sind, kann das eine Weile dauern.

Möchte man Ollama unter Linux komfortabel benutzen, so empfiehlt sich die Installation einer passenden Chatoberfläche wie LibreChat oder AnythingLLM.